¿Qué es ClothOff, IA que crea desnudos falsos de menores de edad y fue eliminada de Telegram?

Una adolescente estadounidense de 17 años ha sufrido secuelas después de que sus compañeros de escuela crearan desnudos falsos de ella a través de ClothOff, un chatbot de inteligencia artificial (IA) generativa que transforma fotos normales en imágenes de carácter sexual. Por esa razón, interpuso una demanda contra los creadores de la plataforma.

Esta herramienta con IA funcionaba a través de Telegram y era capaz de generar tanto imágenes como videos que, a la postre, podían derivar en difamación, extorsión y desinformación, según una propuesta legislativa mexicana de 2023.

ClothOff estuvo disponible a través de la app de mensajería instantánea hasta el lunes 20 de octubre; sin embargo, este martes la aplicación aseguró a Unotv.com que ya fue eliminado.

¿Qué es y cómo funciona ClothOff?

Clothoff.net es “un bot que te ayudará a eliminar todo lo superfluo de una foto”, según la descripción de la propia app que está disponible de manera gratuita a lo largo del mundo y que afirma tener más de 600 mil abonados.

“En el ámbito de la edición fotográfica, Clothoff.net es una fuerza revolucionaria que permite a los usuarios transformar sus imágenes con la tecnología de IA más avanzada”.

ClothOff

El bot de deepnude ofrece una manera de “eliminar elementos no deseados e imperfecciones con precisión”, según la propia plataforma.

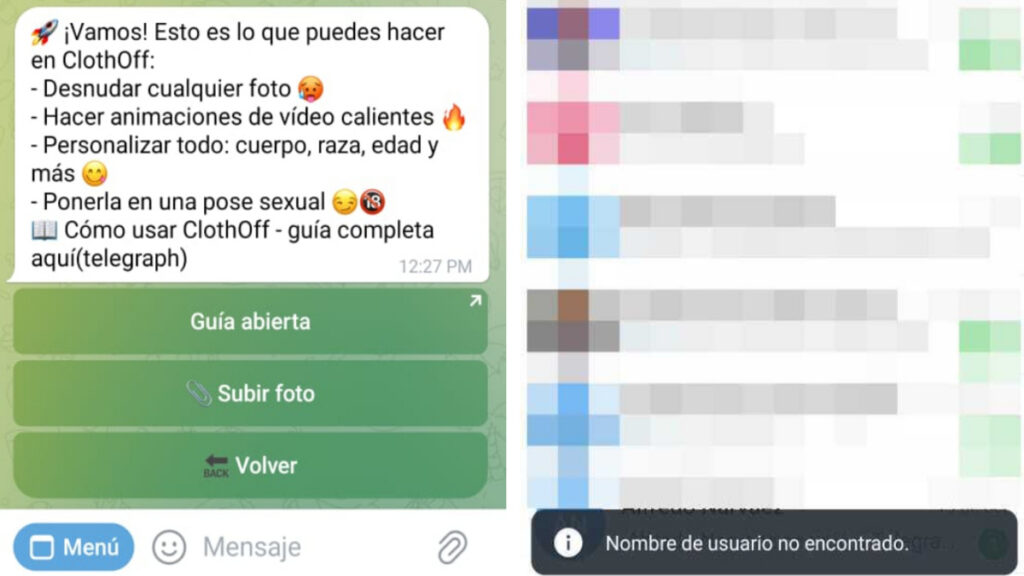

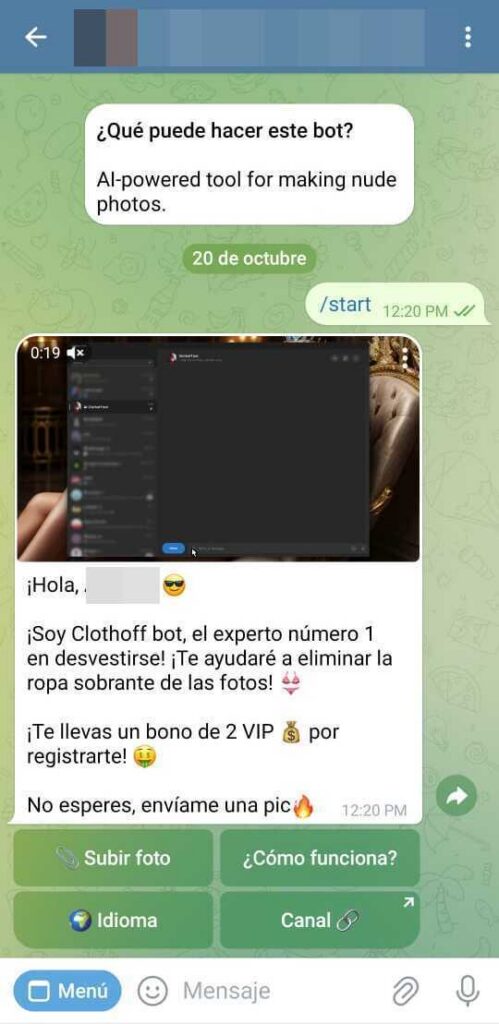

Para acceder a esta herramienta, solo se debía acceder a su canal de Telegram, en donde aparecía el siguiente mensaje: “Herramienta de IA para hacer fotos de desnudos“.

Posteriormente, el usuario se unía al canal y el bot enviaba un mensaje en el que asegura que ayudará al usuario a eliminar la ropa sobrante de las fotos, ofreciendo un bono de “2 VIP” por solo registrarse. Asimismo, ofrecían cuatro opciones:

- Subir foto

- ¿Cómo funciona?

- Idioma

- Canal

Fuente: ClothOff

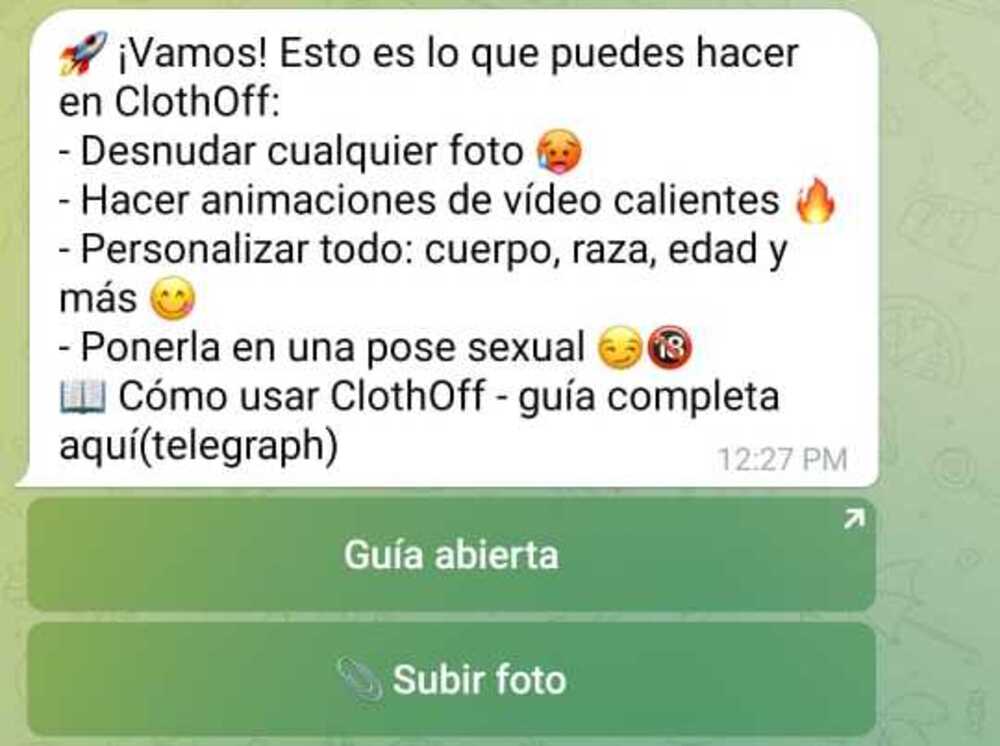

Al dar clic en “¿Cómo funciona?“, el chatbot enviaba todas las funciones que puede brindar a los usuarios:

- Desnudar cualquier foto

- Hacer animaciones de videos calientes

- Personalizar todo: cuerpo, raza, edad y más

- Ponerla en una pose sexual

Fuente: ClothOff

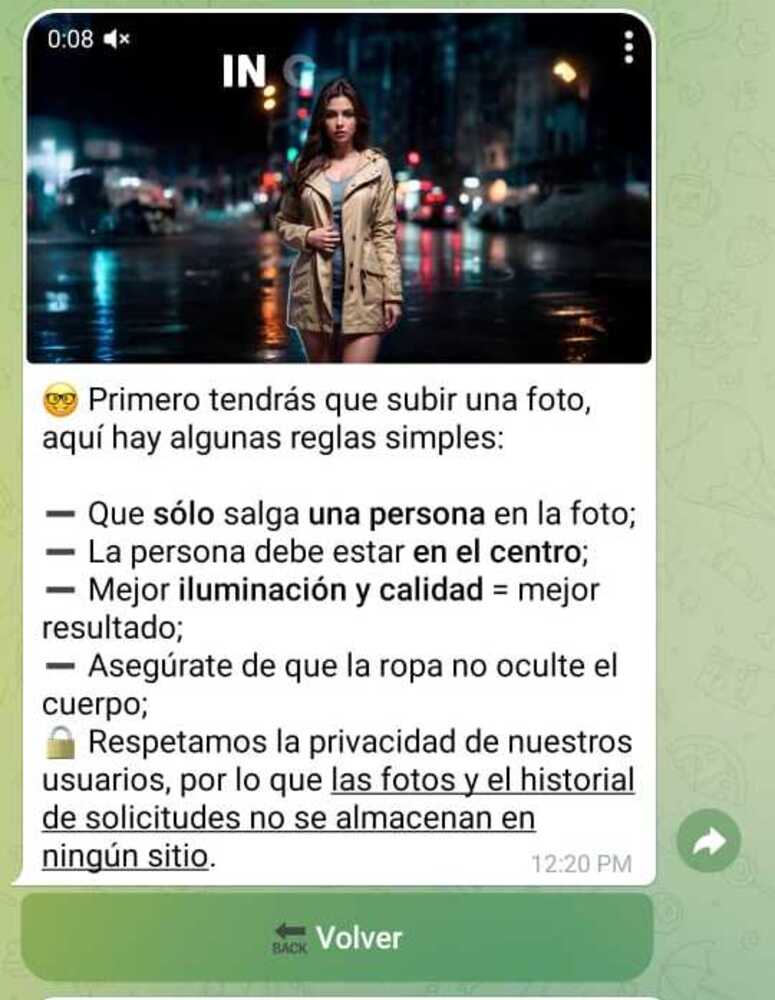

Al dar clic en “Subir foto“, explicaba que la plataforma solo requiere que la persona aparezca en el centro de la foto y que tenga buena iluminación; la única garantía es que las fotos y el historial de solicitudes no se almacenarían en ningún sitio.

Al compartir una foto, el bot preguntaba al usuario cómo le gustaría cambiar el resultado y ofrecía diversas situaciones sexuales. En cuestión de segundos, entregaba una imagen realista de carácter sexual.

Cabe destacar que también brindaba la posibilidad de generar videos cortos a cambio del Bono 2 VIP que se otorgó al momento del registro en Telegram.

“Una vez finalizado el proceso, puedes descargar tu imagen y compartirla con el mundo”, remata ClothOff.

Telegram elimina a ClothOff en México

Este martes 21 de octubre, un portavoz de Telegram Messenger se puso en contacto con Uno TV para confirmar que el bot de ClothOff fue eliminado de la plataforma.

Además, la aplicación de mensajería instantánea afirmó: “La pornografía no consentida y las herramientas para crearla están explícitamente prohibidas por los términos de servicio de Telegram y se eliminan en cuanto se detectan”.

Por esta razón, se confirmó que los moderadores eliminan rutinariamente los bots diseñados para crear pornografía no consentida, incluidas las herramientas ClothOff.

De nueva cuenta, el reportero de este medio pudo confirmar que la app ya no permite ingresar al chatbot.

Advirtieron en México por riesgos con la IA

En 2023, la senadora Gloria Elizabeth Núñez Sánchez presentó una iniciativa para reformar el artículo 199, 200 y 202 del Código Penal Federal.

Su propuesta buscaba sancionar hasta con 12 años de prisión a quien utilice IA para generar imágenes sexuales simuladas de menores, utilizando sus datos biométricos.

La iniciativa fue desechada por falta de antecedentes penales concretos que la respaldaran.

“Los avances en la tecnología de recreación podrían lugar a la creación de imágenes y videos de individuos realizando acciones que nunca llevaron a cabo. Esto podría desencadenar situaciones de difamación, extorsión y desinformación en una escala sin precedentes, afectando a individuos y sociedades enteras”, se leía en la propuesta de la legisladora.

La entonces legisladora también advirtió por la facilidad con la que se pueden fabricar imágenes convincentes, con lo que se podría respaldar afirmaciones falsas o teorías de conspiración, socavando la confiabilidad de la información.

Una adolescente demanda a creadores de ClothOff

Jane Doe, nombre genérico que se usa para no dar a conocer su identidad, es una estudiante de 17 años cuyos compañeros de instituto obtuvieron y usaron imágenes de ella para cargarlas en la aplicación ClothOff.

Con solo unos cuantos clics, obtuvieron una fotografía de la víctima completamente desnuda, “ofreciendo un resultado que no puede diferenciarse de una imagen real”, de acuerdo con Europa Press.

Sigue a Uno TV en Google Discover y consulta las noticias al momento

“Jane Doe estaba mortificada y emocionalmente desconsolada, y ha experimentado consecuencias desde entonces”, recoge el texto de la demanda, presentada en el Tribunal de Distrito de Estados Unidos del Distrito de Nueva Jersey.

Junto a sus padres, Jane Doe demandó a la empresa AI/Robotics Venture Strategy 3, responsable de ClothOff, por considerar que su modelo de negocio facilita la creación de desnudos ilegales.

Además, la demanda acusa la distribución y monetización de las imágenes creadas a través de sus planes de pago e, incluso, a través de la provisión de la tecnología base a desarrolladores y otras plataformas.

Los demandantes también indican que las imágenes hiperrealistas de desnudos que se producen sin el consentimiento de las personas producen “un caldo de cultivo de pornografía infantil, explotación y abuso sexual“.

¿Tienes una denuncia o información que quieras compartir? Escríbenos al WhatsApp de Uno TV: +52 55 8056 9131. Tu mensaje puede hacer la diferencia.

Debido a que no hay forma de determinar hasta qué punto llegaron a distribuirse las imágenes, Jane Doe ahora vive con el temor constante de que su material de abuso sexual infantil (CSAM, por sus siglas en inglés) permanezca disponible en ClothOff y en otros lugares, según se lee en la demanda.

“Le preocupa que esas imágenes puedan distribuirse a otras personas y que su imagen se haya utilizado y se siga utilizando para ayudar a entrenar el sistema de inteligencia artificial de ClothOff para mejorar generar CSAM de otras niñas”.Demanda de Jane Doe a AI/Robotics Venture Strategy 3

Según se recoge en la demanda, ClothOff produce cada día una media de 200 mil imágenes y recibe unas 27 millones de vistas. La propia promoción de la app invita a los usuarios a “desnudas a cualquiera” con su servicio gratuito.

Te recomendamos:

Tecnología

Crean desnudos de menores de edad con IA: adolescente demanda a ClothOff y Telegram elimina este bot

Tecnología

¿Compras en Temu? Nueva estafa usa imagen de aplicación para robar datos bancarios

Tecnología

¡Son una trampa! Usan tutoriales falsos de TikTok para robar información