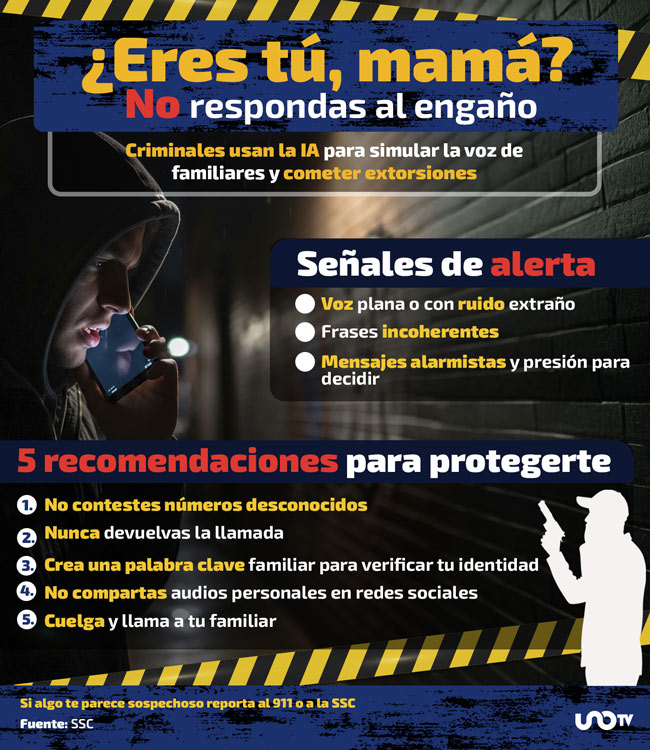

¿Eres tú, mamá? Clonan voces con IA para extorsionar; recomiendan usar palabra clave para no caer en llamadas falsas

Delincuentes pueden clonar la voz de familiares con inteligencia artificial (IA) para engañar y realizar estafas por teléfono, advirtieron expertos en tecnología de Kaspersky y ESET. Y alertaron que con apenas unos segundos de audio, logran recrear voces reales y simular llamadas falsas de emergencia para cometer extorsiones y fraudes.

“Los cibercriminales toman pequeños fragmentos de una grabación real y mediante el uso de la Inteligencia Artificial y los patrones de voz, crean conversaciones y frases para llevar a cabo sus engaños”, explicó ESET.

¿Tienes una denuncia o información que quieras compartir? Escríbenos al WhatsApp de Uno TV: +52 55 8056 9131. Tu mensaje puede hacer la diferencia.

ESET también destacó que el uso de las llamadas falsas, también conocidos como deepfakes de audio va en aumento, así como delitos como los secuestros virtuales, donde los criminales simulan el rapto de un familiar a través de llamadas intimidatorias para exigir un pago de rescate, sin que haya un secuestro físico real. Por ello, recomendaron utilizar una palabra clave familiar que evite caer en engaños durante una llamada.

Usar palabra clave para evitar ser víctima de llamadas falsas a partir de voces con IA

Según el blog oficial de ESET, los criminales ocupan esta técnica especialmente mediante llamadas que simulan situaciones de emergencia o secuestros. Y destacaron que uno de los métodos más efectivos para prevenir este tipo de extorsión es acordar previamente una palabra clave familiar que pueda ser utilizada en situaciones reales y sirva para confirmar si la persona que llama es quien dice ser.

Sigue a Uno TV en Google Discover y consulta las noticias al momento.

“Es importante tener una frase segura, que sea acordada previamente entre familiares y amigos”.

ESET

Sobre la frase segura, la compañía de seguridad destacó que debe ser:

- Simple

- Fácil de recordar

- Diferente de otras contraseñas

“Sólo asegúrate de cambiarlo de vez en cuando, e inmediatamente si crees que ya no es privado”, agregó.

Otras recomendaciones para evitar llamadas falsas son:

- No compartir audios personales en redes sociales

- Usar la verificación en dos pasos

- Sospechar de llamadas con voces extrañas o mensajes alarmistas

¿Cómo identificar un deepfake o llamadas falsas?

Kaspersky recomendó poner atención a las siguientes señales para identificar una llamada falsa:

- Tono de voz plano, forzado o distorsionado

- Incongruencias en lo que se dice o en el contexto del mensaje

- Ausencia de emociones naturales o pausas propias del habla humana

- Presión para tomar decisiones rápidas o entregar datos personales

- Información ilógica, alarmista o inconsistente

“Si recibe una llamada extraña, preste atención a la calidad del sonido. ¿Es en un tono monótono, antinatural o hay ruidos extraños? Recuerda que las principales herramientas de los estafadores son la sorpresa y del pánico”.

Kasperky, empresa de ciberseguridad

Deepfakes y voz clonada: un negocio en crecimiento

De acuerdo con Kaspersky, el mercado negro de contenido falso generado por IA está en auge.

“Los delincuentes ya están utilizando estas tecnologías para evadir controles biométricos y cometer fraudes financieros”.

Isabel Manjarrez, investigadora del Equipo Global de Investigación y Análisis de Kaspersky

Los audios manipulados pueden usarse para acceder a cuentas bancarias, engañar a familiares o manipular conversaciones privadas. Además, se ha documentado que los delincuentes buscan crear contenido en tiempo real, elevando el riesgo de suplantación.